AI-företag som OpenAI, Anthropic och Google har konsekvent hävdat att deras språkmodeller inte lagrar kopior av träningsdata, utan bara ”lär sig mönster”. I inlagor until den amerikanska Copyright Workplace har flera företag aktivt förnekat att deras modeller fungerar som lagringssystem. Males en ny studie från Stanford och Yale, publicerad i januari 2026, slår hål på dessa påståenden.

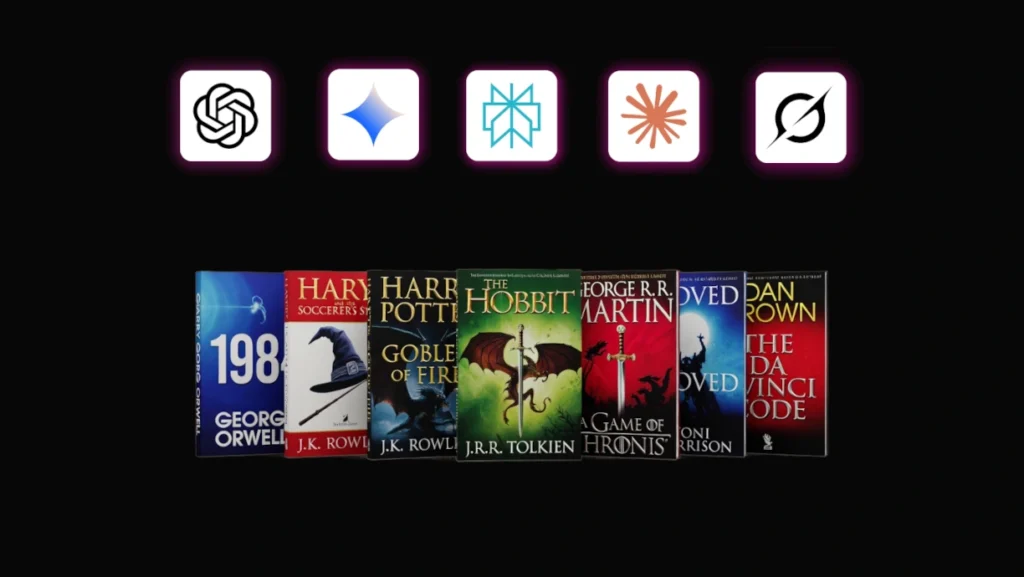

Forskarna testade fyra stora kommersiella AI-modeller: Claude 3.7 Sonnet, GPT-4.1, Gemini 2.5 Professional och Grok 3 – och lyckades extrahera omfattande utdrag från upphovsrättsskyddade böcker. Genom relativt enkla promptningstekniker kunde de få modellerna att reproducera tusentals ord nästan ordagrant från välkända verk.

Hela böcker reproducerade ordagrant

Resultaten är slående. Claude 3.7 Sonnet återskapade George Orwells ”1984” med 94% noggrannhet och ”Harry Potter and the Sorcerer’s Stone” med 96% exakthet. Gemini 2.5 Professional reproducerade Harry Potter med 77% noggrannhet, medan även GPT-4.1 och Grok 3 kunde återskapa betydande delar av texterna.

Fynden utmanar fundamentalt AI-företagens juridiska argument om ”truthful use”. Dessa argument bygger vanligtvis på påståendet att AI-modeller ”transformerar” träningsdata snarare än lagrar och reproducerar den.